Il y a quelques mois, une connaissance se fait donner un iPhone. Formaté. Donc, comme neuf. Amateur d’Android, j’ai passé quelques heures à me démêler, tout installer, tout désactiver ce qui n’était pas nécessaire, et je croyais m’être débarrassé de toutes les “bébelles” inutiles. Quelques mois plus tard, cette connaissance me dit qu’elle a un message disant “qu’elle ne peut plus sauvegarder sur son cellulaire”. Pourtant, c’est faux: Elle peut toujours prendre des photos, télécharger des fichiers, etc. Je réalises ensuite que c’est une erreur reliée à “iCloud”.

- Tu veux savoir ce que tu as dans ton iCloud? Eh ben, bonne chance.

- Tu cherches dans ton cellulaire pour “iCloud” ? Rien.

- Tu cherches dans le “Apple Store” pour iCloud? Rien.

- Eh ben, pour la plupart du monde, je devines que ça finit la, hein.

Une recherche Google m’a menée à la SEULE façon d’aller voir, enfin, les données qu’il y a dans le “iCloud”: le site web iCloud.com.

Aujourd’hui, je réalises que le “problème” était que 5 gigs de photos, vidéos et informations prises avec ce cellulaire ont été sauvegardés quelque part, sur un serveur Apple. Incluant photos et la date et l’endroit ou elles ont été prises. Ah, et ça, c’est si on accède au site web via le cellulaire. Si on y accède via ordinateur, on peut voir aussi que tous les noms, adresse, numéros de téléphone de tous vos contacts sont conservés chez Apple aussi – entre autres.

Donc, en bref, toutes les personnes qui ont un iPhone (ou autre produit avec un système d’exploitation de Apple), qui veulent juste s’en servir et c’est tout, toutes les jeunes et moins jeunes personnes qui prennent des photos d’elles “sexy” ou toutes nues pour envoyer à quelqu’un d’autre, c’est envoyé automatiquement à Apple. Sauvegardé sur leurs serveurs. Sans qu’ils ou elles le sachent. Et la grande majorité ne le sauront fort probablement jamais. À moins d’avoir un avertissement qui dit “votre iCloud est plein” après un certain temps… Un avertissement visible seulement si vous avez pris 5 gigs de photos. Mais même après cet avertissement-là, vous ne trouverez pas d’application iCloud dans votre produit Apple. Ni dans l’App Store. Alors vous vous dites sûrement que votre “téléphone intelligent” est juste bogué, “parce qu’il dit qu’il ne peut rien sauvegarder, mais il y a toujours de l’espace (système) libre pour prendre des photos”.

“Mais non, il faut que tu demandes pour activer ça.”

- En Octobre 2015, à l’aide d’une mise à jour, Apple a activé, par défaut, et sans votre permission, sur tous les systèmes iOS, ces sauvegardes iCloud. Donc depuis Octobre 2015, tout ça se fait automatiquement, et ce jusqu’à concurrence de 5 gigs de données.

- En janvier 2020, Apple a annulé l’idée d’encrypter vos propres données de façon à ce que seul vous puissiez les voir, parce que “le FBI n’était pas d’accord avec l’idée”.

- Pas étonnant: Aujourd’hui, je tombes sur une firme de surveillance qui dit, dans une conférence privée secrètement enregistrée, que Apple est “phénoménal” pour aider la police (et le FBI, etc). “Apple est connu pour ne pas débarrer les iPhones des gens lorsqu’un officier leur demande, mais va donner toute l’information des sauvegardes iCloud qui sont sur leurs serveurs.”

Donc, vos données iCloud (qui sont, précisément: toutes vos photos prises avec votre produit Apple, la date et l’endroit ou elles ont été prises, tous les noms, adresses, numéros de téléphone de tous vos contacts, ainsi que tous vos messages, pour ne nommer que ça), est accessible par les gens de chez Apple, même si vous ne leur avez rien demandé. Vous pouvez au moins vous réconforter en vous disant que les gens chez Apple peuvent “juste” se crosser sur un maximum de 5 gigs de photos de jeunes par cellulaire.

C’est pas fini: Apple CSAM.

En Août 2021, Apple a annoncé “CSAM”. Un “système de détection d’images pédopornographiques”. Parfait …en théorie. En pratique? Ça confirme doublement que les gens de chez Apple peuvent voir toutes les photos que vous avez sur iCloud et qu’ils peuvent y accéder (…si ce n’est pas déjà fait, parce que, pourquoi pas? C’est leurs serveurs!), et que lorsque “CSAM”, qui est simplement un programme informatique, croit qu’une photo est celle d’une personne mineure nue, des personnes chez Apple vont les regarder, pour voir si c’est le cas (ou si c’est “juste” une personne de 18 ans ou plus nue que vous aviez dans votre iCloud). Et vu que vous avez “choisi” (sans votre permission) d’avoir un acompte iCloud, “vous aviez déjà donné votre accord pour la détection CSAM dans votre cloud, c’est juste que vous ne le saviez pas”. Vous aviez déjà donné la permission à Apple de tout savoir et tout voir à propos de vous – hey, incluant les photos de vos propres enfants nus si vous en avez, hein. Parce que si vous en avez sur votre produit Apple, eh bien je vous annonce qu’Apple les a aussi. Sinon, je me demandes comment ils vont faire pour savoir si une personne nue a 17 ou 18 ans? L’appeler à son propre numéro de téléphone pour lui demander?

Je vous rappelle qu’en 2012, un prêtre pédophile travaillait pour un aéroport aux États-Unis, payé pour regarder les “scanners” qui montraient le corps complet nu de tous les adultes et enfants qui y passaient.

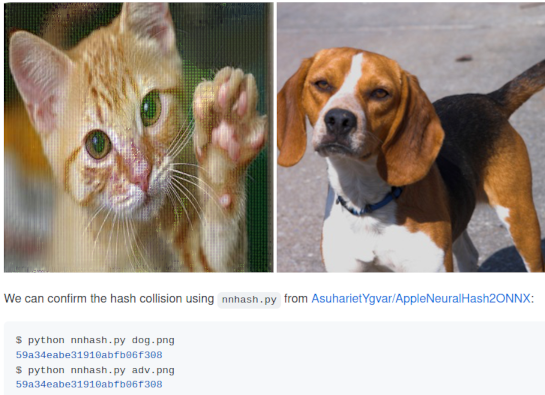

Le “CSAM”, c’est simplement un “algorithme de reconnaissance visuelle”. En Septembre 2021, un mois après l’annonce de Apple, des gens ont réussi à contrer un algorithme similaire… avec du maquillage. Apple dit qu’on ne doit pas s’inquiéter “pour la vie privée”, parce que “CSAM est basé sur la signature d’une image” (donc, la “signature” d’images pédopornographiques connues). Eh ben, Neural Hash Collider est un programme libre et gratuit, que n’importe qui peut déjà télécharger, qui permet carrément de changer la signature de n’importe quelle image, pour faire croire au CSAM, entre autres, que cette photo de chat est une photo de chien.

Ouep. Selon le CSAM de Apple, ces deux photos sont les mêmes. Pourquoi est-ce même possible de faire ça? Parce que les informations à propos du fonctionnement de CSAM ont déjà été publiées, et, bref, CSAM est loin de fonctionner aussi bien qu’on le prétend. En plus, loi des grands nombres oblige, beaucoup d’images auront la même signature. Si le programme ne peut même pas différencier une photo de chat d’une photo de chien, je crois que le nombre infini de “faux positifs” (sur “5 gigs de photos multiplié par le nombre de personnes qui ont leurs photos sur iCloud, incluant la grande majorité des gens qui ne savent même pas que leurs photos y sont”) va faire en sorte que des dizaines de personnes chez Apple vont passer leur temps à regarder vos photos, pour rien.

Je rappelles aussi qu’en 2017, la police Brittanique utilisait une IA pour chercher de la porno, mais l’IA n’arrêtait pas de croire que des photos du désert, c’était des photos de femmes nues. Comme disait l’autre… “send dunes”.

Pour terminer, bien sûr que si CSAM ou quelque chose de similaire fonctionnerait correctement, c’est-à-dire trouverait les images pédopornographiques connues et enverrait les pédos en prison, sans donner à quiconque le droit de regarder les photos de personnes qui n’ont rien à voir avec ça, je n’aurais rien contre. Mais c’est absolument tout le contraire qui se passe, à l’insu de gens qui n’ont absolument pas été informés de quoique ce soit. En plus, en fait, ironiquement, on informe carrément les pédos de l’existence de CSAM avant de le mettre en marche? C’est à se demander si le but de Apple est vraiment de contrer la pédopornographie, ou juste d’avoir une IA qui leur donne le privilège d’avoir la plus grosse base de données de pornographie amateur de l’histoire de l’humanité, réservée aux personnes qui travaillent chez Apple, sans que ces amateurs, mineur-e-s ou pas, le sachent (incluant, possiblement, vous).

En résumé, si vous tenez à votre vie privée, abandonnez Apple.